7 Minutės

Nauja Pensilvanijos universiteto tyrimų ataskaita rodo, kad dirbtinis intelektas gali iš nuotraukų išgauti asmenybės požymius ir naudoti juos profesiniams rezultatams prognozuoti. Ši išvada kelia svarbių klausimų dėl automatizuotos atrankos, kreditavimo sprendimų ir etikos, susijusios su veido analizės naudojimu kaip įdarbinamumo rodikliu.

Kaip atliktas tyrimas — veidai, algoritmai ir „Didysis penketukas“

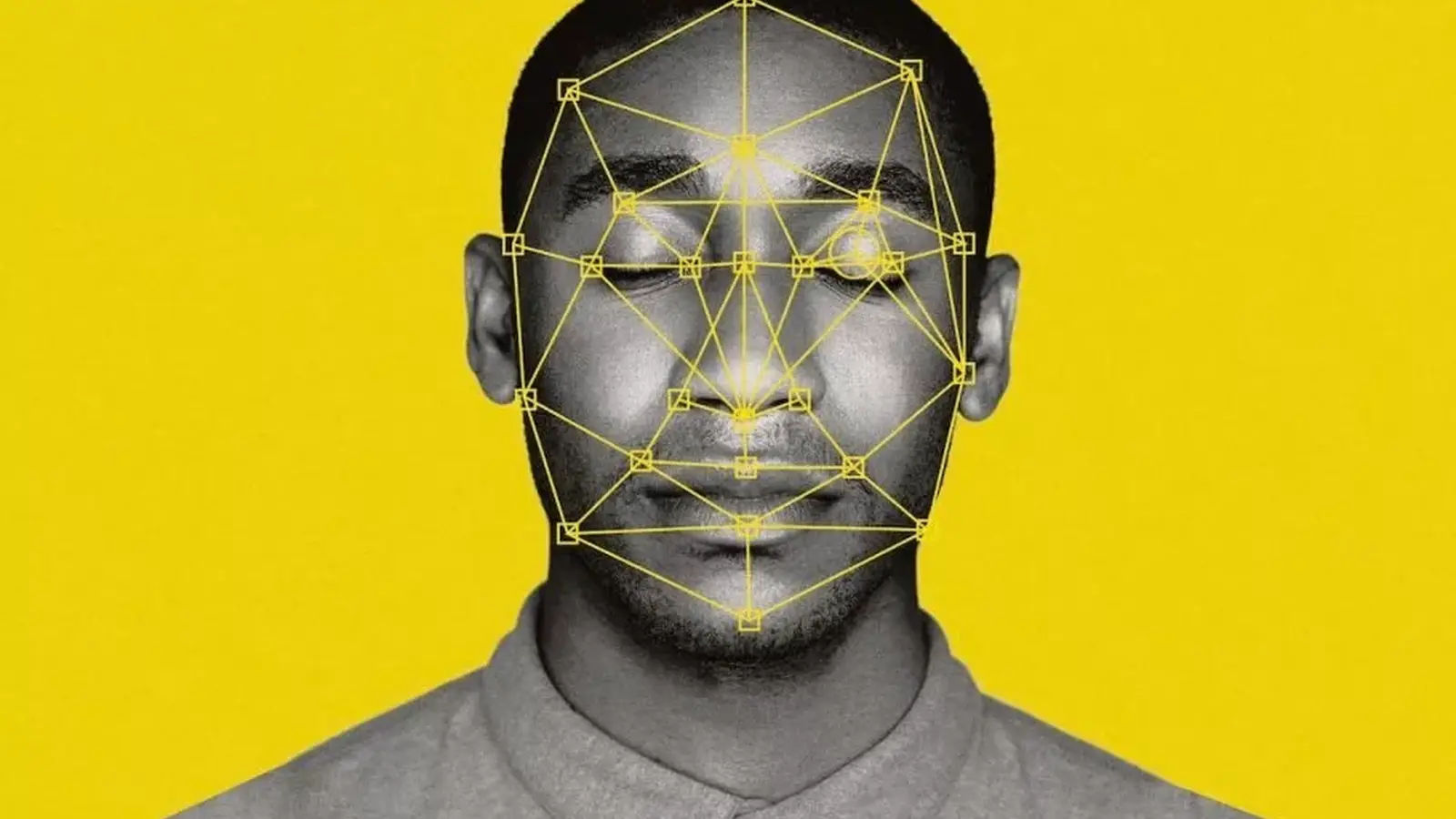

Tyrėjų grupė apmokė mašininio mokymosi modelį remdamasi ankstesniais darbais, kuriuose buvo nagrinėjamas veido išvaizdos ryšys su asmenybės bruožais. Jie surinko 96 000 MBA absolventų profilio nuotraukų iš LinkedIn ir panaudojo AI sistemą, kad įvertintų penkis pagrindinius asmenybės bruožus — atvirumą (openness), sąžiningumą (conscientiousness), ekstraversiją (extraversion), draugiškumą (agreeableness) ir neurotiškumą (neuroticism), dažnai vadinamus „Didžiuoju penketuku“.

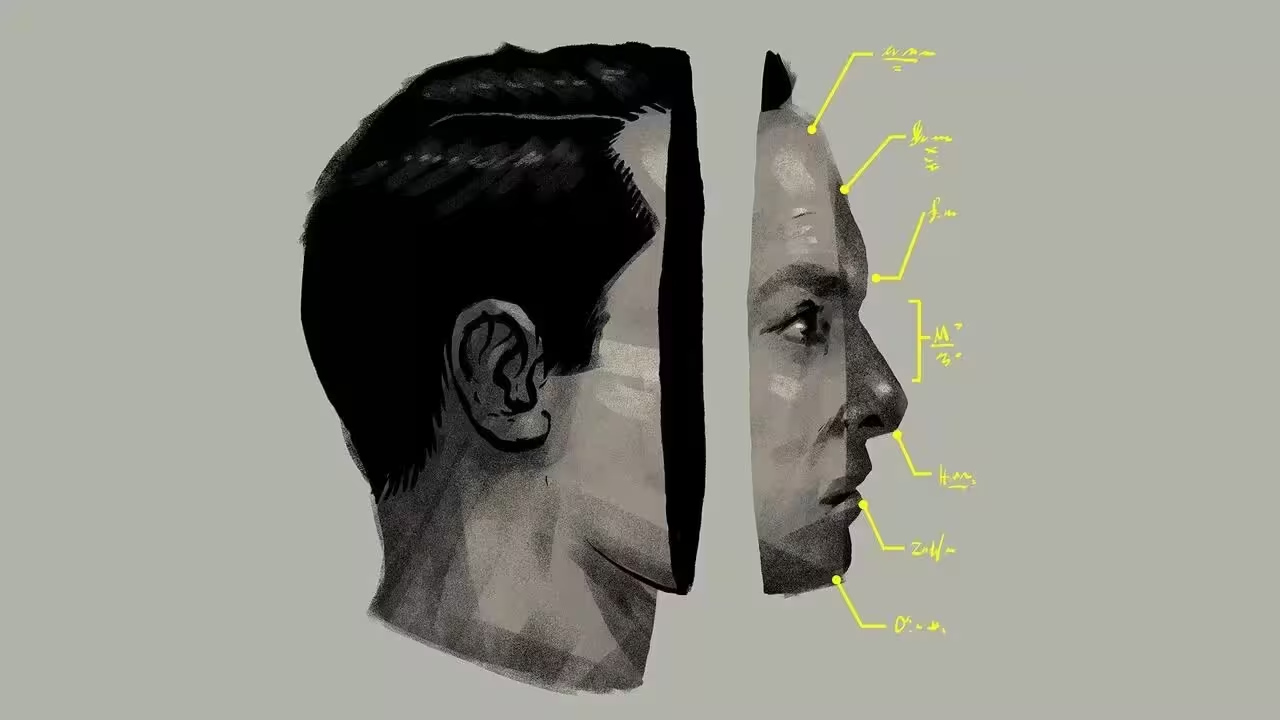

Metodologija apėmė ne tik nuotraukų rinkimą, bet ir ankstesnių publikacijų bei anotuotų duomenų panaudojimą modelio apmokymui. Dalyje tyrimo buvo taikyti įvairūs kompiuterinio regėjimo metodai — nuo tradicinių veido žymenų (angl. landmarks) iki giluminio mokymosi neuroninių tinklų, optimizuotų charakteristikų išgavimui iš pikselių. Siekta, kad modelis ne tiesiog atpažintų tapatybę, o išvestų stochastines įverčias, susijusias su kiekvienu asmenybės matu.

Iš pikselių į asmenybės įverčius

AI nuskenavo veido bruožus, išskyrė morfologines ir tekstūrines savybes, o vėliau pateikė įverčius kiekvienam asmenybės požymiui. Tyrėjai tuos įverčius lygino su realiais karjeros rodikliais, įskaitant pajamas, pareigas, karjeros trajektorijas ir kitus darbo rinkos rezultatus. Analizė parodė statistiškai reikšmingus koreliacijos ryšius: akivaizdiausias teigiamas koreliatorius aukštesniam atlyginimui buvo veido įtariama ekstraversija, o modelio išvesta atvirumo reikšmė šiame imtyje koreliavo su žemesnėmis pajamomis.

Svarbu pabrėžti, kad koreliacija neįrodo priežasties ir efektų mechanizmo. Modelis nerodo, kodėl tam tikra veido išraiška ar bruožas asocijuojasi su karjeros rezultatais; jis tik atpažįsta statistinius ryšius, kuriuos gali lemti daugybė tarpininkaujančių veiksnių — socialinė kilmė, kultūriniai bruožai, nuotraukų stilius arba net profesionalaus profilio redagavimas. Be to, tokie modeliai linkę užfiksuoti ir sustiprinti istorines šališkumas, esantys mokymo duomenyse.

Kodėl tai svarbu: įdarbinimas, kreditavimas ir algoritminis teisingumas

Paskaičiuokime galimus scenarijus: automatizuotos atrankos sistemos, kurios prie CV ir pokalbių prideda veido analizės sluoksnį, galėtų būti naudojamos optimizuojant įdarbinimo sprendimus, nuomos sutarčių tvirtinimą ar kreditavimo procesus. Žiniasklaidoje, tarp jų ir „The Economist“, bei SSCN paskelbtoje darbo versijoje pažymėta, kad finansiškai motyvuotos įmonės gali įsivertinti tokias priemones siekdamos sumažinti kaštus arba padidinti efektyvumą.

Tačiau toks perspektyvos įgyvendinimas kelia rimtų etinių ir teisinio pobūdžio pavojų. Atmetant kandidatą vien dėl to, kad algoritmas veide „sumatė“ nepageidaujamą asmenybės bruožą, rizikuojama įtvirtinti diskriminaciją ir pažeisti lygiateisiškumo principus. Tokios praktikos gali netiesiogiai diskriminuoti grupei priklausančius asmenis pagal lytį, amžių, rasę, etninę kilmę ar kitas apsaugotas savybes, ypač jei mokymo duomenys nėra adekvačiai subalansuoti.

Tiek darbdaviai, tiek skolintojai privalo įvertinti ne tik potencialią naudą, bet ir teisines bei reputacijos rizikas. Algoritmų veikimo principai, duomenų šaltiniai ir tikslumo rodikliai turi būti skaidrūs, prieinamai auditavimo ir kontroliavimo institucijoms. Kitaip tariant, reikia aiškių procesų, kaip tokie sprendimai priimami, kokiais atvejais sistemų išvados naudojamos ir kokios žmogaus priežiūros priemonės egzistuoja.

Tyrimo autoriai pataria elgtis atsargiai. Jie modelio rezultatus apibūdina kaip papildomą informacijos šaltinį, o ne kaip galutinį įrodymą apie asmens charakterį ar ateitį. Veido analizės sritis, kai kalbama apie elgesio bruožus, yra vis dar ankstyvoje stadijoje, o tikslumas svyruoja priklausomai nuo populiacijos, kultūrinio konteksto ir fotografavimo sąlygų. Netikslumai gali sustiprinti socialines nelygybes, jeigu darbdaviai, bankai ar nuomotojai pradės laikyti algoritminių įverčių sprendimus lemiamais.

Galimi privalumai, realios rizikos ir netyčinės pasekmės

Taisyklėse yra ir argumentų už: šalininkai teigia, kad veido analizė gali būti naudinga ten, kur trūksta kitų duomenų. Pavyzdžiui, kreditavimo atvejais, kai asmuo neturi kredito istorijos (angl. thin-file), papildoma informacija galėtų padėti priimti sprendimą. Tačiau net ir tokiose situacijose būtina atidžiai vertinti modelio patikimumą ir galimą auditorinių klaidų įtaką.

Tyrime taip pat įspėjama apie ilgalaikes elgesio pasekmes: plačiai paplitusi veido analizės priemonių naudojimo praktika gali paskatinti žmones keičiantis elgtis ar net koreguoti savo išvaizdą (skaitmeniniu būdu arba kosmetinėmis procedūromis), siekiant palankesnių algoritminių įverčių. Tai kuria naują visuomeninę dinamiką, kur asmens reprezentacija internete tampa strategine intervencija, o ne natūralia saviraiška.

Be to, egzistuoja sudėtingi teisinių ir techninių sprendimų klausimai. Veido atpažinimo ir asmenybės spėjimo įrankiai kirstis su privatumo įstatymais, anti-diskriminacijos nuostatais ir formuojamaisiais reikalavimais dėl automatizuotų sprendimų sistemų. Be stiprios skaidrumo, audito ir teisingumo politikos rizikuojama sukelti žalą dideliu mastu — nuo neteisingų atmetimų darbo rinkoje iki neadekvačių kreditavimo nutarimų, kurie gali paveikti asmens ekonominę gerovę.

Techniniai iššūkiai apima duomenų kokybę, reprezentatyvumą, modelio generalizaciją ir atsparumą triukšmui. Dažnai AI modeliai veikia gerai tose populiacijose, kuriose jie buvo apmokyti, bet prastai perneša žinias į kitus demografinius kontingentus. Tai reiškia, kad modelio tikslumo rodikliai turi būti lyginami tarp grupių (angl. subgroup analysis) ir, jei reikia, įdiegiamos korekcijos, kad būtų sumažinta algoritminė šališkumas.

Organizacijoms, svarstančioms tokias priemones, rekomenduojama atlikti išankstinį poveikio vertinimą (angl. algorithmic impact assessment), nustatyti aiškius sprendimų ribojimus, įgyvendinti žmonių peržiūros mechanizmus ir sudaryti nuolatinius auditus. Tokie žingsniai padeda ne tik teisiniam atitikimui, bet ir reputacijai bei ilgalaikiam verslo tvarumui.

Ko verta stebėti toliau

Mokslininkai tęsia tyrimus, ar veido išvestiniai signalai turi prognostinę vertę skirtingose darbo rinkose ir demografinėse grupėse. Nepriklausomas tyrimų pakartojamumas, atviri duomenų rinkiniai ir viešoji politikos diskusija bus esminiai veiksniai, lemiantys, ar ir kaip AI asmenybės prognozavimas gali būti teisėtai ir etiškai naudojamas įdarbinime ar kreditų patikrinimuose.

Finansų institucijoms, viešosioms agentūroms ir darbdaviams rekomenduojama bendradarbiauti su akademine bendruomene ir pilietinėmis organizacijomis, siekiant nustatyti saugias, skaidrias ir teisingas naudojimo ribas. Tai apima atvirą rezultatų dokumentavimą, prieinamą prieigą prie auditavimo įrankių bei nustatytas procedūras, ką daryti, jei modelio sprendimai prieštarauja teisiniams ar etiniams standartams.

Technologijų kūrėjai turėtų investuoti į technikas, skirtas mažinti šališkumą (angl. bias mitigation), įdiegti įvairių demografinių grupių testavimą ir užtikrinti, kad sistemos pateiktų ne tik prognozes, bet ir aiškų neapibrėžtumo bei pasitikėjimo įvertinimą. Tokie matavimai gali padėti sprendimų priėmėjams suprasti, kada modelio įverčiai yra pakankamai patikimi arba priešingai — per daug rizikingi, kad būtų naudojami be žmogaus intervencijos.

Galiausiai, visuomenės diskusija apie privatumo normas ir informuotą sutikimą skaitmeninėje erdvėje taps kritiniu kontekstu. Vartotojai privalo žinoti, ką reiškia duoti leidimą analizuoti savo profilio nuotraukas, kokie yra galimi padariniai ir kokios teisės jiems priklauso. Viešojo sektoriaus vaidmuo — nustatyti minimalias apsaugos normas ir reglamentuoti, kur ir kaip tokios technologijos gali būti naudojamos — išliks kertinis elementas, norint apsaugoti piliečių teises.

Trumpai tariant, šis tyrimas primena, kad mašininis mokymasis sugeba rasti žmonėms nematomus šablonus — tačiau šablonas nėra įrodymas. Politikos formuotojai, darbdaviai ir technologijų kūrėjai turi atsakingai subalansuoti galimą naudingumą su grėsmėmis teisingumui, privatumui ir asmeninei autonomijai.

Šaltinis: smarti

Palikite komentarą